通过分析器理解查询执行

ClickHouse 处理查询非常快速,但查询的执行并非一个简单的故事。让我们尝试理解 SELECT 查询是如何执行的。为了说明这一点,让我们在 ClickHouse 的表中添加一些数据

CREATE TABLE session_events(

clientId UUID,

sessionId UUID,

pageId UUID,

timestamp DateTime,

type String

) ORDER BY (timestamp);

INSERT INTO session_events SELECT * FROM generateRandom('clientId UUID,

sessionId UUID,

pageId UUID,

timestamp DateTime,

type Enum(\'type1\', \'type2\')', 1, 10, 2) LIMIT 1000;

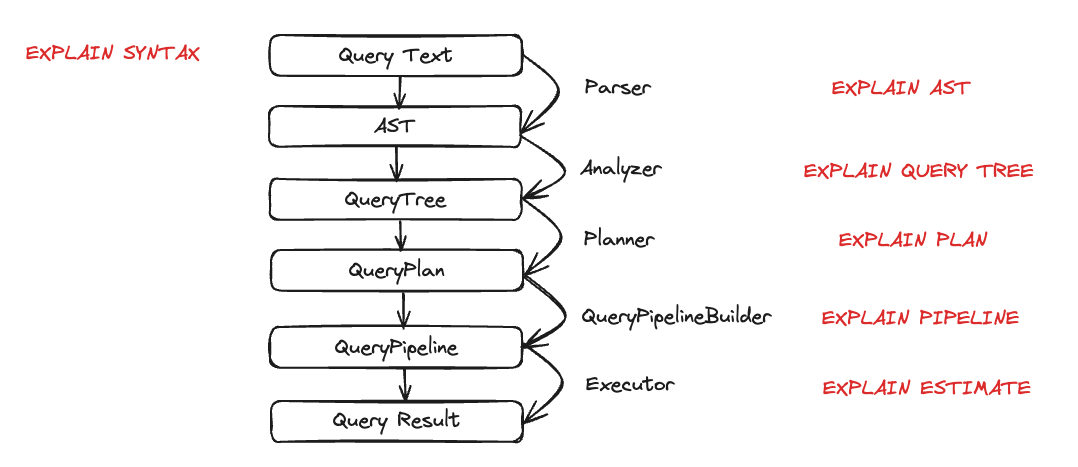

现在我们已经在 ClickHouse 中有一些数据,我们想要运行一些查询并理解它们的执行过程。查询的执行分解为多个步骤。可以使用相应的 EXPLAIN 查询来分析和排除查询执行的每个步骤。这些步骤总结在下面的图表中

让我们看看每个实体在查询执行期间的动作。我们将选取几个查询,然后使用 EXPLAIN 语句检查它们。

解析器

解析器的目标是将查询文本转换为 AST(抽象语法树)。可以使用 EXPLAIN AST 可视化此步骤

EXPLAIN AST SELECT min(timestamp), max(timestamp) FROM session_events;

┌─explain────────────────────────────────────────────┐

│ SelectWithUnionQuery (children 1) │

│ ExpressionList (children 1) │

│ SelectQuery (children 2) │

│ ExpressionList (children 2) │

│ Function min (alias minimum_date) (children 1) │

│ ExpressionList (children 1) │

│ Identifier timestamp │

│ Function max (alias maximum_date) (children 1) │

│ ExpressionList (children 1) │

│ Identifier timestamp │

│ TablesInSelectQuery (children 1) │

│ TablesInSelectQueryElement (children 1) │

│ TableExpression (children 1) │

│ TableIdentifier session_events │

└────────────────────────────────────────────────────┘

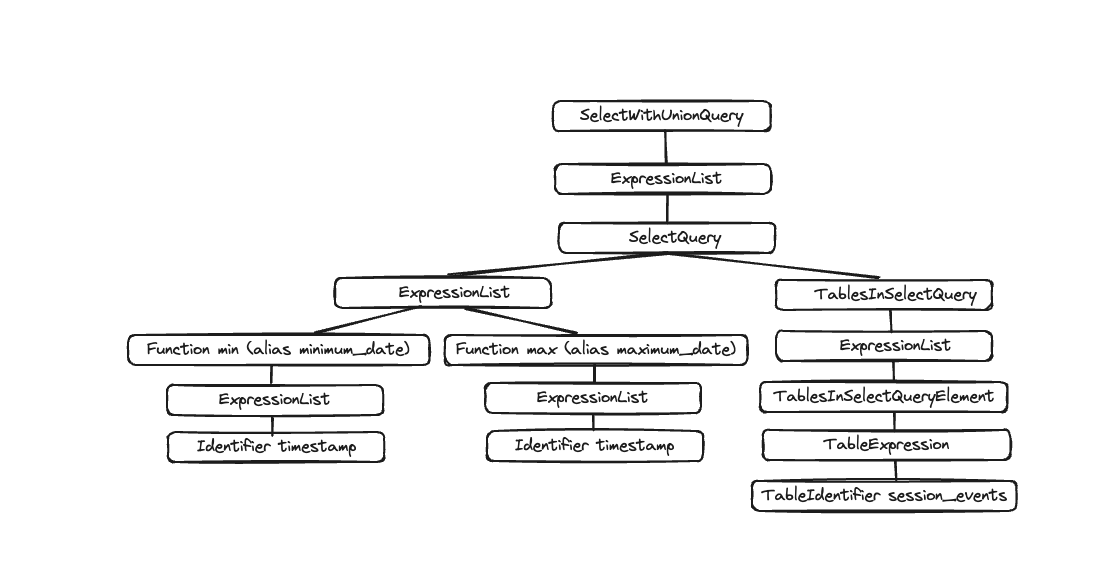

输出是一个抽象语法树,可以可视化,如下所示

每个节点都有相应的子节点,整个树代表了查询的总体结构。这是一个帮助处理查询的逻辑结构。从最终用户的角度来看(除非对查询执行感兴趣),它不是非常有用;此工具主要供开发人员使用。

分析器

ClickHouse 当前为分析器提供了两种架构。您可以通过设置 enable_analyzer=0 来使用旧架构。默认情况下启用新架构。鉴于一旦新的分析器普遍可用,旧架构将被弃用,我们将在此处仅描述新架构。

新架构应为我们提供更好的框架来提高 ClickHouse 的性能。但是,鉴于它是查询处理步骤的基本组件,它也可能对某些查询产生负面影响,并且存在已知的不兼容性。您可以通过在查询或用户级别更改 enable_analyzer 设置来恢复到旧的分析器。

分析器是查询执行的重要步骤。它接收 AST 并将其转换为查询树。查询树相对于 AST 的主要优点是,许多组件将被解析,例如存储。我们还知道从哪个表读取数据,别名也被解析,并且树知道所使用的不同数据类型。凭借所有这些优点,分析器可以应用优化。这些优化的工作方式是通过“passes”(阶段)。每个阶段都将寻找不同的优化。您可以在此处查看所有阶段,让我们通过之前的查询在实践中看看它

EXPLAIN QUERY TREE passes=0 SELECT min(timestamp) AS minimum_date, max(timestamp) AS maximum_date FROM session_events SETTINGS allow_experimental_analyzer=1;

┌─explain────────────────────────────────────────────────────────────────────────────────┐

│ QUERY id: 0 │

│ PROJECTION │

│ LIST id: 1, nodes: 2 │

│ FUNCTION id: 2, alias: minimum_date, function_name: min, function_type: ordinary │

│ ARGUMENTS │

│ LIST id: 3, nodes: 1 │

│ IDENTIFIER id: 4, identifier: timestamp │

│ FUNCTION id: 5, alias: maximum_date, function_name: max, function_type: ordinary │

│ ARGUMENTS │

│ LIST id: 6, nodes: 1 │

│ IDENTIFIER id: 7, identifier: timestamp │

│ JOIN TREE │

│ IDENTIFIER id: 8, identifier: session_events │

│ SETTINGS allow_experimental_analyzer=1 │

└────────────────────────────────────────────────────────────────────────────────────────┘

EXPLAIN QUERY TREE passes=20 SELECT min(timestamp) AS minimum_date, max(timestamp) AS maximum_date FROM session_events SETTINGS allow_experimental_analyzer=1;

┌─explain───────────────────────────────────────────────────────────────────────────────────┐

│ QUERY id: 0 │

│ PROJECTION COLUMNS │

│ minimum_date DateTime │

│ maximum_date DateTime │

│ PROJECTION │

│ LIST id: 1, nodes: 2 │

│ FUNCTION id: 2, function_name: min, function_type: aggregate, result_type: DateTime │

│ ARGUMENTS │

│ LIST id: 3, nodes: 1 │

│ COLUMN id: 4, column_name: timestamp, result_type: DateTime, source_id: 5 │

│ FUNCTION id: 6, function_name: max, function_type: aggregate, result_type: DateTime │

│ ARGUMENTS │

│ LIST id: 7, nodes: 1 │

│ COLUMN id: 4, column_name: timestamp, result_type: DateTime, source_id: 5 │

│ JOIN TREE │

│ TABLE id: 5, alias: __table1, table_name: default.session_events │

│ SETTINGS allow_experimental_analyzer=1 │

└───────────────────────────────────────────────────────────────────────────────────────────┘

在两次执行之间,您可以看到别名和投影的解析。

计划器

计划器接收查询树并从中构建查询计划。查询树告诉我们想要对特定查询做什么,而查询计划告诉我们将如何做。其他优化将作为查询计划的一部分完成。您可以使用 EXPLAIN PLAN 或 EXPLAIN 查看查询计划(EXPLAIN 将执行 EXPLAIN PLAN)。

EXPLAIN PLAN WITH

(

SELECT count(*)

FROM session_events

) AS total_rows

SELECT type, min(timestamp) AS minimum_date, max(timestamp) AS maximum_date, count(*) /total_rows * 100 AS percentage FROM session_events GROUP BY type

┌─explain──────────────────────────────────────────┐

│ Expression ((Projection + Before ORDER BY)) │

│ Aggregating │

│ Expression (Before GROUP BY) │

│ ReadFromMergeTree (default.session_events) │

└──────────────────────────────────────────────────┘

即使这为我们提供了一些信息,我们还可以获得更多。例如,也许我们想知道我们需要投影的列名。您可以将标头添加到查询中

EXPLAIN header = 1

WITH (

SELECT count(*)

FROM session_events

) AS total_rows

SELECT

type,

min(timestamp) AS minimum_date,

max(timestamp) AS maximum_date,

(count(*) / total_rows) * 100 AS percentage

FROM session_events

GROUP BY type

┌─explain──────────────────────────────────────────┐

│ Expression ((Projection + Before ORDER BY)) │

│ Header: type String │

│ minimum_date DateTime │

│ maximum_date DateTime │

│ percentage Nullable(Float64) │

│ Aggregating │

│ Header: type String │

│ min(timestamp) DateTime │

│ max(timestamp) DateTime │

│ count() UInt64 │

│ Expression (Before GROUP BY) │

│ Header: timestamp DateTime │

│ type String │

│ ReadFromMergeTree (default.session_events) │

│ Header: timestamp DateTime │

│ type String │

└──────────────────────────────────────────────────┘

所以现在您知道需要为最后一次投影(minimum_date、maximum_date 和 percentage)创建的列名,但您可能还想了解需要执行的所有操作的详细信息。您可以通过设置 actions=1 来做到这一点。

EXPLAIN actions = 1

WITH (

SELECT count(*)

FROM session_events

) AS total_rows

SELECT

type,

min(timestamp) AS minimum_date,

max(timestamp) AS maximum_date,

(count(*) / total_rows) * 100 AS percentage

FROM session_events

GROUP BY type

┌─explain────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────┐

│ Expression ((Projection + Before ORDER BY)) │

│ Actions: INPUT :: 0 -> type String : 0 │

│ INPUT : 1 -> min(timestamp) DateTime : 1 │

│ INPUT : 2 -> max(timestamp) DateTime : 2 │

│ INPUT : 3 -> count() UInt64 : 3 │

│ COLUMN Const(Nullable(UInt64)) -> total_rows Nullable(UInt64) : 4 │

│ COLUMN Const(UInt8) -> 100 UInt8 : 5 │

│ ALIAS min(timestamp) :: 1 -> minimum_date DateTime : 6 │

│ ALIAS max(timestamp) :: 2 -> maximum_date DateTime : 1 │

│ FUNCTION divide(count() :: 3, total_rows :: 4) -> divide(count(), total_rows) Nullable(Float64) : 2 │

│ FUNCTION multiply(divide(count(), total_rows) :: 2, 100 :: 5) -> multiply(divide(count(), total_rows), 100) Nullable(Float64) : 4 │

│ ALIAS multiply(divide(count(), total_rows), 100) :: 4 -> percentage Nullable(Float64) : 5 │

│ Positions: 0 6 1 5 │

│ Aggregating │

│ Keys: type │

│ Aggregates: │

│ min(timestamp) │

│ Function: min(DateTime) → DateTime │

│ Arguments: timestamp │

│ max(timestamp) │

│ Function: max(DateTime) → DateTime │

│ Arguments: timestamp │

│ count() │

│ Function: count() → UInt64 │

│ Arguments: none │

│ Skip merging: 0 │

│ Expression (Before GROUP BY) │

│ Actions: INPUT :: 0 -> timestamp DateTime : 0 │

│ INPUT :: 1 -> type String : 1 │

│ Positions: 0 1 │

│ ReadFromMergeTree (default.session_events) │

│ ReadType: Default │

│ Parts: 1 │

│ Granules: 1 │

└────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────┘

您现在可以看到正在使用的所有输入、函数、别名和数据类型。您可以在此处查看计划器将应用的一些优化。

查询管道

查询管道从查询计划生成。查询管道与查询计划非常相似,不同之处在于它不是树而是图。它突出了 ClickHouse 将如何执行查询以及将使用哪些资源。分析查询管道对于查看输入/输出方面的瓶颈非常有用。让我们采用之前的查询并查看查询管道的执行情况

EXPLAIN PIPELINE

WITH (

SELECT count(*)

FROM session_events

) AS total_rows

SELECT

type,

min(timestamp) AS minimum_date,

max(timestamp) AS maximum_date,

(count(*) / total_rows) * 100 AS percentage

FROM session_events

GROUP BY type;

┌─explain────────────────────────────────────────────────────────────────────┐

│ (Expression) │

│ ExpressionTransform × 2 │

│ (Aggregating) │

│ Resize 1 → 2 │

│ AggregatingTransform │

│ (Expression) │

│ ExpressionTransform │

│ (ReadFromMergeTree) │

│ MergeTreeSelect(pool: PrefetchedReadPool, algorithm: Thread) 0 → 1 │

└────────────────────────────────────────────────────────────────────────────┘

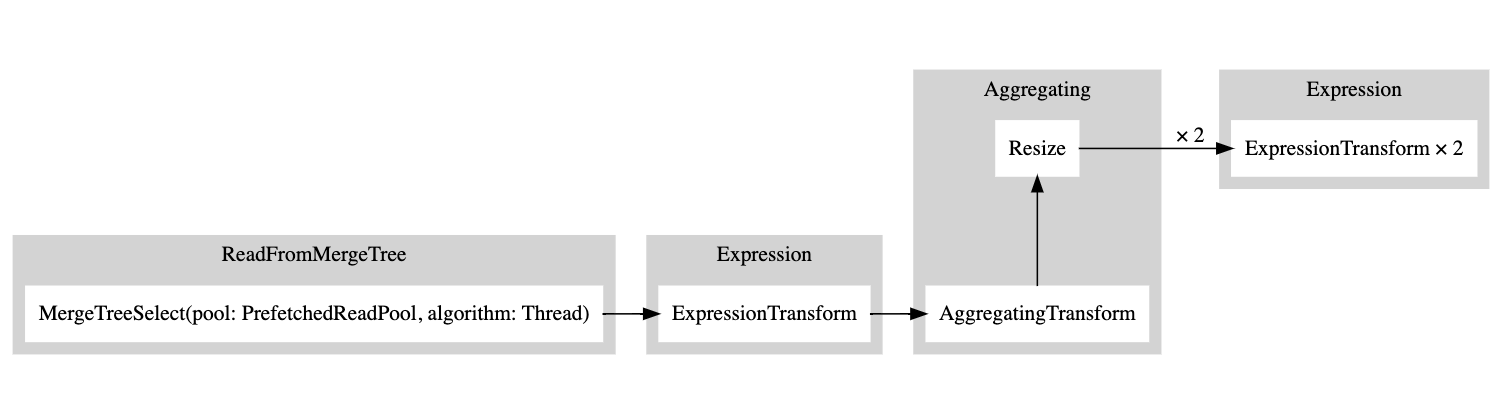

括号内是查询计划步骤,旁边是处理器。这是很棒的信息,但是鉴于这是一个图,如果能将其可视化就更好了。我们有一个设置 graph,我们可以将其设置为 1 并指定输出格式为 TSV

EXPLAIN PIPELINE graph=1 WITH

(

SELECT count(*)

FROM session_events

) AS total_rows

SELECT type, min(timestamp) AS minimum_date, max(timestamp) AS maximum_date, count(*) /total_rows * 100 AS percentage FROM session_events GROUP BY type FORMAT TSV;

digraph

{

rankdir="LR";

{ node [shape = rect]

subgraph cluster_0 {

label ="Expression";

style=filled;

color=lightgrey;

node [style=filled,color=white];

{ rank = same;

n5 [label="ExpressionTransform × 2"];

}

}

subgraph cluster_1 {

label ="Aggregating";

style=filled;

color=lightgrey;

node [style=filled,color=white];

{ rank = same;

n3 [label="AggregatingTransform"];

n4 [label="Resize"];

}

}

subgraph cluster_2 {

label ="Expression";

style=filled;

color=lightgrey;

node [style=filled,color=white];

{ rank = same;

n2 [label="ExpressionTransform"];

}

}

subgraph cluster_3 {

label ="ReadFromMergeTree";

style=filled;

color=lightgrey;

node [style=filled,color=white];

{ rank = same;

n1 [label="MergeTreeSelect(pool: PrefetchedReadPool, algorithm: Thread)"];

}

}

}

n3 -> n4 [label=""];

n4 -> n5 [label="× 2"];

n2 -> n3 [label=""];

n1 -> n2 [label=""];

}

然后,您可以复制此输出并将其粘贴到此处,这将生成以下图

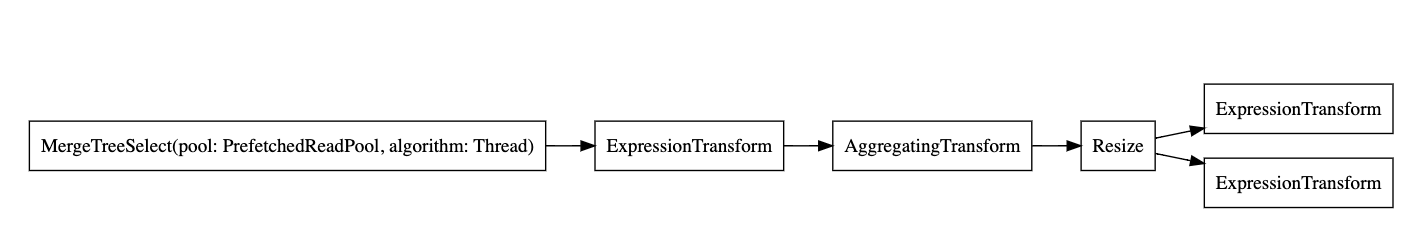

白色矩形对应于管道节点,灰色矩形对应于查询计划步骤,x 后跟一个数字对应于正在使用的输入/输出的数量。如果您不想以紧凑的形式查看它们,您可以随时添加 compact=0

EXPLAIN PIPELINE graph = 1, compact = 0

WITH (

SELECT count(*)

FROM session_events

) AS total_rows

SELECT

type,

min(timestamp) AS minimum_date,

max(timestamp) AS maximum_date,

(count(*) / total_rows) * 100 AS percentage

FROM session_events

GROUP BY type

FORMAT TSV

digraph

{

rankdir="LR";

{ node [shape = rect]

n0[label="MergeTreeSelect(pool: PrefetchedReadPool, algorithm: Thread)"];

n1[label="ExpressionTransform"];

n2[label="AggregatingTransform"];

n3[label="Resize"];

n4[label="ExpressionTransform"];

n5[label="ExpressionTransform"];

}

n0 -> n1;

n1 -> n2;

n2 -> n3;

n3 -> n4;

n3 -> n5;

}

为什么 ClickHouse 不使用多线程从表中读取数据?让我们尝试向表中添加更多数据

INSERT INTO session_events SELECT * FROM generateRandom('clientId UUID,

sessionId UUID,

pageId UUID,

timestamp DateTime,

type Enum(\'type1\', \'type2\')', 1, 10, 2) LIMIT 1000000;

现在让我们再次运行我们的 EXPLAIN 查询

EXPLAIN PIPELINE graph = 1, compact = 0

WITH (

SELECT count(*)

FROM session_events

) AS total_rows

SELECT

type,

min(timestamp) AS minimum_date,

max(timestamp) AS maximum_date,

(count(*) / total_rows) * 100 AS percentage

FROM session_events

GROUP BY type

FORMAT TSV

digraph

{

rankdir="LR";

{ node [shape = rect]

n0[label="MergeTreeSelect(pool: PrefetchedReadPool, algorithm: Thread)"];

n1[label="MergeTreeSelect(pool: PrefetchedReadPool, algorithm: Thread)"];

n2[label="ExpressionTransform"];

n3[label="ExpressionTransform"];

n4[label="StrictResize"];

n5[label="AggregatingTransform"];

n6[label="AggregatingTransform"];

n7[label="Resize"];

n8[label="ExpressionTransform"];

n9[label="ExpressionTransform"];

}

n0 -> n2;

n1 -> n3;

n2 -> n4;

n3 -> n4;

n4 -> n5;

n4 -> n6;

n5 -> n7;

n6 -> n7;

n7 -> n8;

n7 -> n9;

}

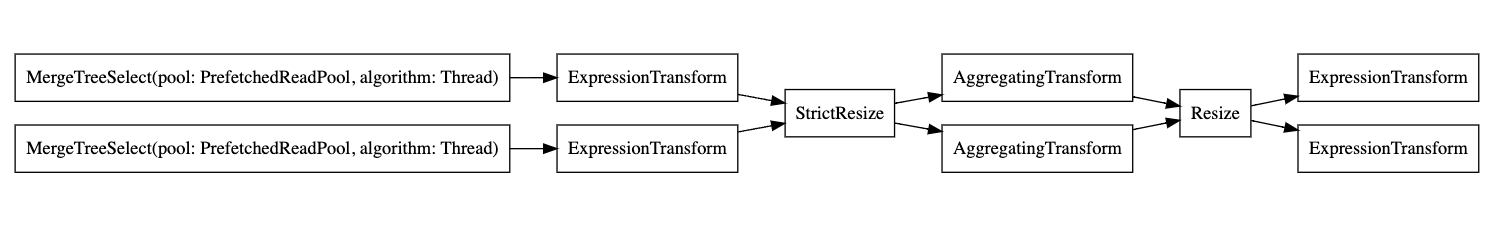

因此,执行器决定不并行化操作,因为数据量不够大。通过添加更多行,执行器随后决定使用多个线程,如图所示。

执行器

最后,查询执行的最后一步由执行器完成。它将接收查询管道并执行它。根据您执行的是 SELECT、INSERT 还是 INSERT SELECT,有不同类型的执行器。